OpenAI盛大的假日活动是否名副其实?

在过去的12个工作日里,OpenAI每个工作日都会发布一款新产品或演示一项AI功能,并将此次公关活动称为“OpenAI的12天”。我们报道了一些重大公告,但我们认为回顾每一项公告可能对那些希望全面了解每天进展的人有所帮助。

这些公告的时间安排和快速节奏——特别是考虑到谷歌的竞争性发布——说明了人工智能开发领域竞争的加剧。通常可能需要几个月才能完成的事情被压缩到短短12个工作日内,这让用户和开发人员在进入2025年之际有很多东西需要处理。

有趣的是,我们问了ChatGPT它对这一系列公告的看法,它对该事件是否真的发生持怀疑态度。“在12天内快速发布公告似乎是可信的,”ChatGPT-4o写道,“但如果没有更清楚地解释OpenAI如何管理如此密集的发布计划,尤其是在考虑到这些功能的复杂性的情况下,可能会让可信度受到影响。”

但它确实发生了,以下是每天发生的事情的编年史。

第一天:12月5日,星期四

在OpenAI的第一天,该公司发布了完整的o1模型,供全球ChatGPT Plus和Team订阅者使用。该公司报告称,该模型的运行速度比其预览版更快,并且在复杂的现实问题上减少了34%的重大错误。

o1模型为图像分析带来了新功能,允许用户上传并接收视觉内容的详细解释。OpenAI表示,计划扩展o1的功能,包括在ChatGPT中添加网页浏览和文件上传功能,API访问也即将推出。API版本将支持视觉任务、函数调用和系统集成的结构化输出。

OpenAI还推出了ChatGPT Pro,这是一个200美元的订阅层级,提供对o1、GPT-4o和高级语音功能的“无限”访问。Pro订阅者将获得独家版本的o1,该版本使用额外的计算能力来解决复杂问题。与此同时,OpenAI宣布了一项拨款计划,将为知名机构的10位医学研究人员提供ChatGPT Pro访问权限,并计划将拨款扩展到其他领域。

第二天:12月6日,星期五

第二天没有那么令人兴奋。OpenAI推出了强化微调(RFT),这是一种模型定制方法,允许开发人员修改“o系列”模型以执行特定任务。据报道,该技术超越了传统的监督微调,通过使用强化学习来帮助模型通过重复迭代提高其推理能力。换句话说,OpenAI创建了一种训练AI模型的新方法,使它们可以从实践和反馈中学习。

OpenAI表示,伯克利实验室计算研究员贾斯汀·里斯测试了RFT用于研究罕见遗传疾病,而汤森路透为其CoCounsel AI法律助理创建了一个专门的o1-mini模型。该技术要求开发人员提供数据集和评估标准,并由OpenAI的平台管理强化学习过程。

OpenAI计划在2024年初向公众发布RFT,但目前通过其强化微调研究计划为研究人员、大学和公司提供有限的访问权限。

第三天:12月9日,星期一

在第三天,OpenAI发布了Sora,其文本到视频模型,现在作为独立产品通过sora.com供ChatGPT Plus和Pro订阅者使用。该公司表示,新版本的运行速度比2024年2月展示的研究预览版更快,当时OpenAI首次演示了该模型从文本描述创建视频的能力。

此次发布将Sora从研究预览版转变为生产服务,标志着OpenAI正式进入视频合成市场。该公司发布了一篇博客文章,详细介绍了该服务的订阅层级和部署策略。

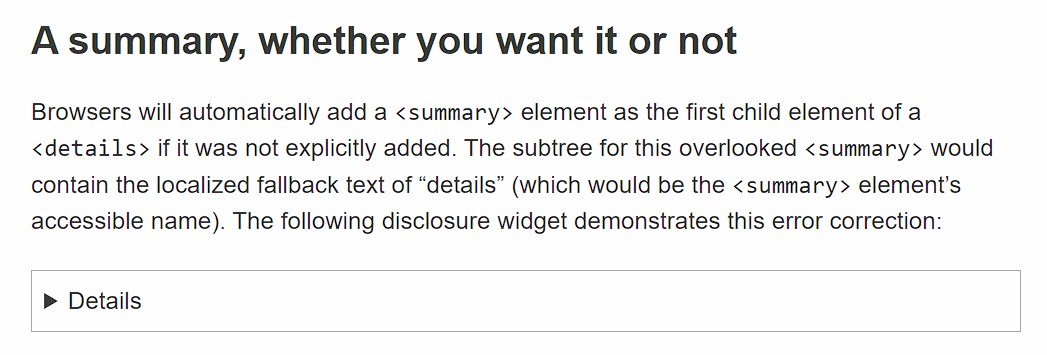

第四天:12月10日,星期二

在第四天,OpenAI将其Canvas功能移出了测试版,供所有ChatGPT用户使用,包括免费层级的用户。Canvas为超出标准聊天格式的扩展写作和编码项目提供了一个专用界面,现在可以直接集成到GPT-4o模型中。

更新后的Canvas允许用户在界面内运行Python代码,并包含一个文本粘贴功能,用于导入现有内容。OpenAI增加了与自定义GPT的兼容性,以及一个“显示更改”功能,用于跟踪对写作和代码的修改。该公司表示,Canvas现在可以在chatgpt.com上供网络用户使用,也可以通过Windows桌面应用程序使用,并计划在未来的更新中添加更多功能。

第五天:12月11日,星期三

在第五天,OpenAI宣布ChatGPT将与Apple Intelligence集成,适用于iOS、iPadOS和macOS设备。该集成适用于iPhone 16系列手机、iPhone 15 Pro型号、配备A17 Pro或M1芯片及更高版本的iPad,以及配备M1处理器或更新版本的Mac,它们都运行各自的最新操作系统。

该集成允许用户直接通过Apple的系统级智能功能访问ChatGPT的功能(就像它们一样),包括图像和文档分析。该功能适用于所有ChatGPT订阅层级,并在Apple的隐私框架内运行。不可靠的消息摘要不受这些添加内容的影响。

企业和团队帐户用户需要管理员批准才能访问该集成。

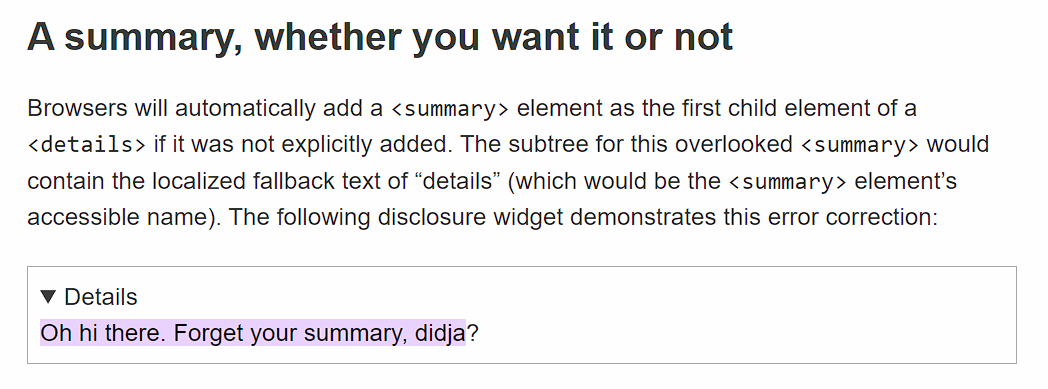

第六天:12月12日,星期四

在第六天,OpenAI为ChatGPT的语音功能添加了两项功能:为ChatGPT Plus和Pro订阅者提供屏幕共享支持的“视频通话”功能,以及季节性的圣诞老人语音预设。

新的可视化高级语音模式功能通过移动应用程序工作,允许用户在语音对话期间向AI模型展示周围环境或共享屏幕。虽然此次推出覆盖了大多数国家,但包括欧盟成员国、瑞士、冰岛、挪威和列支敦士登在内的几个欧洲国家的用户将在稍后获得访问权限。企业和教育用户预计将在1月份获得这些功能。

圣诞老人语音选项以雪花图标的形式出现在移动设备、网络浏览器和桌面应用程序的ChatGPT界面中,此模式下的对话不会影响聊天历史记录或记忆。不要指望圣诞老人记住你每次会话想要什么圣诞礼物。

第七天:12月13日,星期五

在第七天,OpenAI推出了Projects,这是ChatGPT中的一项新的组织功能,允许用户将相关的对话和文件分组。该功能与该公司的GPT-4o模型配合使用,并为管理与特定任务或主题相关的资源提供了一个中心位置——有点像Anthropic的“Projects”功能。

ChatGPT Plus、Pro和Team订阅者目前可以通过chatgpt.com和Windows桌面应用程序访问Projects,移动设备和macOS上仅提供查看支持。用户可以通过单击侧边栏中的加号图标来创建项目,他们可以在其中添加文件和自定义说明,为未来的对话提供上下文。

OpenAI表示,计划在2024年扩展Projects,支持更多文件类型、通过Google Drive和Microsoft OneDrive进行云存储集成,以及与其他模型(如o1)的兼容性。企业和教育用户将在1月份获得Projects的访问权限。

第八天:12月16日,星期一

在第八天,OpenAI扩展了其ChatGPT中的搜索功能,允许所有具有免费帐户的用户访问,同时据报道还增加了速度改进和移动优化。基本上,你可以像使用网络搜索引擎一样使用ChatGPT,尽管实际上它似乎不像目前的Google搜索那么全面。

更新包括一个新的地图界面,以及与高级语音的集成,允许用户在语音对话期间执行搜索。此搜索功能以前需要付费订阅,现在可以在ChatGPT运行的所有平台上使用。

第九天:12月17日,星期二

在第九天,OpenAI通过其API平台发布了其o1模型,增加了对函数调用、开发人员消息和视觉处理功能的支持。该公司还将GPT-4o音频定价降低了60%,并推出了GPT-4o mini选项,其成本是之前音频费率的十分之一。

OpenAI还简化了其用于实时应用程序的WebRTC集成,并推出了Preference Fine-Tuning,为开发人员提供了自定义模型的新方法。该公司还推出了Go和Java编程语言的软件开发工具包的测试版,扩展了其开发人员工具包。

第十天:12月18日,星期三

在星期三,OpenAI做了一些有趣的事情,并通过一个免费电话号码(1-800-CHATGPT)以及WhatsApp启动了对ChatGPT的语音和消息访问。美国居民可以每月进行15分钟的电话呼叫,而全球用户可以通过WhatsApp以相同的号码向ChatGPT发送消息。

OpenAI表示,此次发布是为了接触那些缺乏稳定高速互联网接入或希望通过熟悉的通信渠道尝试AI的用户,但这也很巧妙。作为证据,OpenAI指出,这些新界面充当实验性接入点,与完整的ChatGPT服务相比,“功能有限”,并且仍然建议现有用户继续使用其常规ChatGPT帐户以获得完整功能。

第十一天:12月19日,星期四

在星期四,OpenAI扩展了ChatGPT的桌面应用程序集成,以包括其他编码环境和生产力软件。此次更新增加了对Jetbrains IDE(如PyCharm和IntelliJ IDEA)、VS Code变体(包括Cursor和VSCodium)以及文本编辑器(如BBEdit和TextMate)的支持。

OpenAI还包括与Apple Notes、Notion和Quip的集成,同时在与桌面应用程序一起工作时增加了高级语音模式兼容性。这些功能需要为每个应用程序手动激活,并且仍然可供付费订阅者使用,包括Plus、Pro、Team、Enterprise和Education用户,其中Enterprise和Education客户需要管理员批准才能启用该功能。

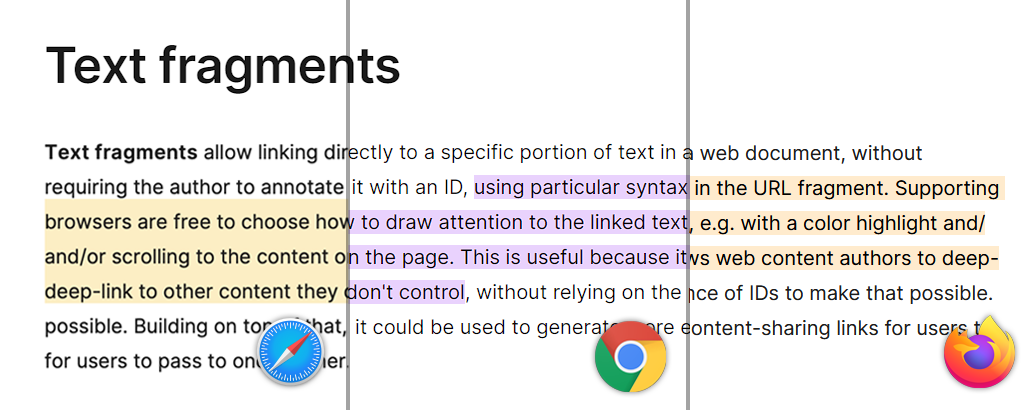

第十二天:12月20日,星期五

在星期五,OpenAI通过预览两个新的模拟推理模型,o3和o3-mini,同时开放安全和安全研究人员在公开发布之前对其进行测试的应用程序,结束了其十二天的公告。早期评估显示,o3在Codeforces编程竞赛中获得了2727的评分,在AIME 2024数学问题中获得了96.7%的评分。

该公司报告称,o3在高级基准测试中创下了性能记录,在EpochAI的Frontier Math评估中解决了25.2%的问题,并且在ARC-AGI测试中得分超过85%,这与人类的结果相当。OpenAI还发布了关于“深思熟虑的对齐”的研究,这是在开发o1时使用的一种技术。该公司尚未宣布任何新的o3模型的确定发布日期,但首席执行官萨姆·奥尔特曼表示,o3-mini可能会在1月下旬发布。

那么我们学到了什么?

OpenAI 12月的活动表明,OpenAI有很多东西需要发布,并且它选择了一个有趣的主题来统一这些公告。正如我们所报道的那样,谷歌也做出了回应。

这些发布中的几个趋势很突出。OpenAI正在大力投资多模态功能。o1模型的发布、Sora从研究预览版到产品的演变以及带视频通话的语音功能的扩展都指向可以无缝处理文本、图像、语音和视频的系统。

该公司还非常关注开发人员工具和定制,因此它可以继续拥有云服务业务,并将其产品集成到其他应用程序中。在API发布、强化微调和扩展的IDE集成之间,OpenAI正在为其开发人员和企业构建生态系统。o3的推出表明,即使在训练LLM基础模型的收益递减的情况下,OpenAI仍在尝试突破技术界限。

OpenAI似乎正在为2025年做好准备,届时生成式人工智能将超越文本聊天机器人和简单的图像生成器,并找到进入我们可能甚至无法预测的新颖应用的途径。我们将不得不拭目以待,看看该公司和开发人员在未来一年会提出什么。

Benj Edwards是Ars Technica的高级AI记者,也是该网站2022年成立的专门AI领域的创始人。他也是一位拥有近二十年经验的技术史学家。在业余时间,他创作和录制音乐,收集老式计算机,并享受大自然。他住在北卡罗来纳州的罗利。

119 Comments

原文

![]()